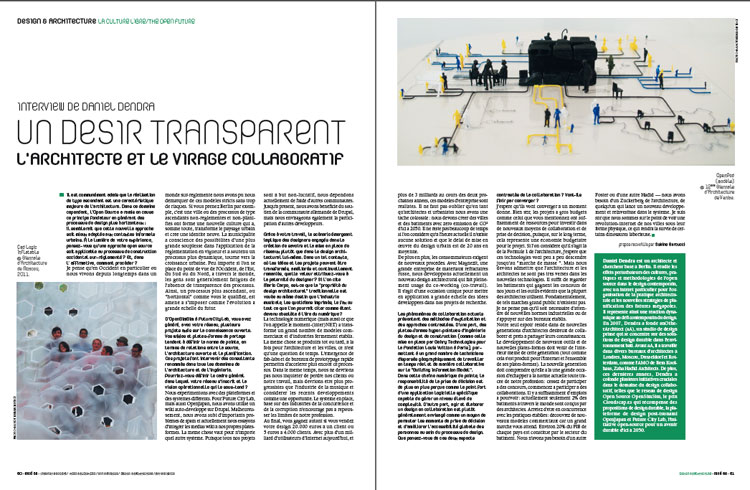

archives vidéo à l’ère numérique

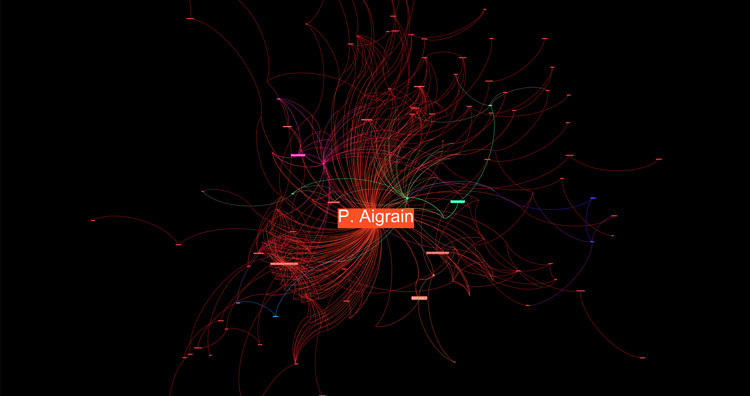

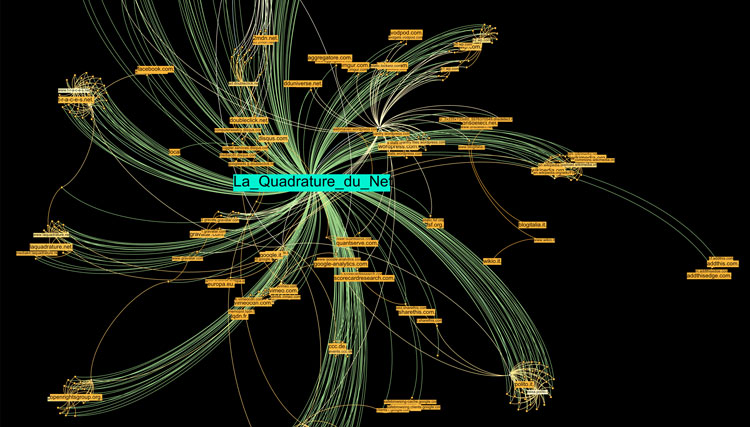

Les questions soulevées par l’archivage audio et vidéo à l’ère numérique constituent sans aucun doute l’un des points de contact majeurs entre la philosophie de l’open source et les pratiques artistiques audio et vidéo. Ici, l’archive se définit comme un ensemble de systèmes, de méthodes et d’expériences dans l’élaboration de la collection, la diffusion et l’accès à la connaissance. Inutile de dire que ce qui relie les concepts d’open source et d’archive à UbuWeb est commun à la plupart des protagonistes impliqués dans l’histoire de l’expérimentation audiovisuelle en milieu universitaire, la recherche, l’enseignement, l’étude ou plus généralement à ceux qui s’aventurent dans la recherche — trop souvent ardue — de contenu audiovisuel documentant l’histoire de l’avant-garde.

Kenneth Goldsmith @ Street Poets and Visionaries, Mercer Union. Toronto, 2009. Photo: © C. Jones.

Alors que bon nombre d’organisations dédiées à la « préservation du patrimoine audiovisuel » s’efforcent de résoudre le conflit apparent entre la protection du droit d’auteur et le réseau de diffusion, UbuWeb a fait du libre accès et du mépris du droit d’auteur le symbole et l’instrument de sa révolution. L’expérience d’UbuWeb est unique et absolue, comme son fondateur Kenneth Goldsmith nous le rappelle avec emphase, amenant à se demander comment le projet a pu survivre jusqu’à nos jours. En effet, il s’est développé tout en restant conforme à son principe fondateur.

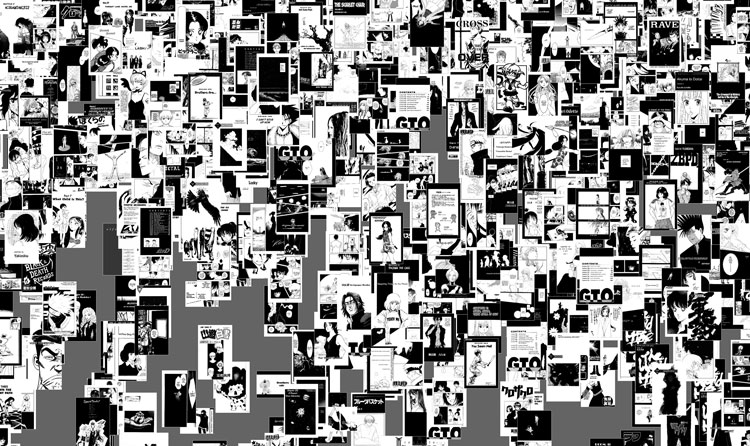

Kenneth Goldsmith, poète, enseignant et rédacteur en chef du projet PennSound, a fondé UbuWeb en 1996 pour mettre à disposition des œuvres d’art visuel et de poésie concrète. C’est ainsi que la mise en ligne de contenu, introuvable ou épuisé, a commencé. Dès le début, des genres et des catégories de contenu mis à disposition ont quelque peu dépassé les frontières des arts visuels et de la poésie concrète : la poésie sonore a été la première catégorie à ouvrir la voie, à partir de là, s’est rajouté toute la musique d’avant-garde, jusqu’à la création de la section « Film », qui héberge environ 7 500 titres et auteurs. Ce mélange, cette hybridation des disciplines, forme la caractéristique principale du projet, déterminé à encourager des rapports alchimiques entre musique, poésie, littérature, cinéma et vidéo, essais et articles.

Toutes les interviews publiées, le grand nombre d’informations contenues sur le site et le manifeste même du projet rappellent deux règles fondamentales : UbuWeb ne reçoit aucun fond public ou privé et diffuse le contenu sans demander de permission, parce que si nous avions dû demander la permission tout ceci n’existerait pas (1). Nous n’avons pas demandé à Goldsmith comment ils parvenaient à réaliser ce rêve partagé par de nombreux partisans de l’accès libre (freeaccess, open access) et du P2P, parce que cette question a déjà été posée à d’innombrables reprises. Il n’est pas difficile de trouver sa réponse sur le net, qui dit en substance : nous le faisons, c’est tout. Comme vous pourrez le lire dans ses propos, Goldsmith est réticent quand il s’agit de réfléchir ou de faire des comparaisons entre l’expérience d’UbuWeb et le discours plus général de la relation entre archives et accès libre En fait, l’expérience d’UbuWeb est une anomalie au niveau des deux pôles, l’antithétique de ce domaine.

UbuWeb s’éloigne manifestement d’une archive audiovisuelle traditionnelle. Le projet semble plus proche de la dynamique de l’échange P2P, avec laquelle il partage souvent la source de ses contenus, mais aussi l’accès gratuit. Pourtant, UbuWeb est radicalement différent du P2P en ce qu’il ne respecte pas la structure horizontale caractéristique de l’échange P2P, mais suit un schéma à sens unique allant du haut vers le bas, établissant une modalité de transmission des connaissances selon une distribution multivoque (one-to-many).

Pour UbuWeb, le partage est en fait un cadeau (2), mais d’une manière qui contredit celle décrite par Marcel Mauss (3) : elle ne permet ni ne vise à construire une relation, il refuse même toute possibilité de réponse à son offre. Le don d’UbuWeb rappelle la définition du don par Derrida (4) : pour qu’il y ait don, il faut qu’il n’y ait pas de réciprocité de retour, d’échange, de contre-don ni de dette. Si l’autre me rend ou me doit, ou doit me rendre ce que je lui donne il n’y aura pas eu don, que cette restitution soit immédiate ou qu’elle se programme dans le calcul complexe d’une différence à long terme (5).

Selon cette formulation, le don représente l’une des formes les plus radicales de la perturbation de l’économie de marché, de par l’élimination de son rapport d’échange lui-même. Dans ce cadre, UbuWeb joue un rôle particulièrement important en ce qui concerne l’un des aspects plus problématiques de la production de l’open source. Bien qu’apparaissant comme une stratégie innovatrice, la production de l’open source est intégrée aux échanges et aux marchés propres à l’économie capitaliste et continue ainsi à en dépendre. Si le marché définit la valeur des produits culturels, alors, le rôle d’UbuWeb est de préserver les objets qui s’en sont échappés, en ont été rejetés ou se sont dissous dans les limbes de ce même marché (œuvres épuisées ou jamais publiés) et fonctionne de façon très similaire à celle des magasins gratuits, dans lesquels des produits sont donnés, perdant ainsi leur valeur marchande tout en conservant leur valeur d’usage.

UbuWeb est né il y a 15 ans. Au regard de ces années d’activité. Dans quelle mesure le projet a-t-il changé et quelles sont les futures évolutions envisageables…

Très peu de choses ont changé. UbuWeb fait à peu près la même chose qu’à ses débuts : il distribue gratuitement des œuvres d’avant-garde à n’importe qui à travers le monde. L’avenir suivra cette même ligne. Peut-être qu’une nouvelle section ouvrira ici et là, mais nous n’avons pas l’intention de changer quoi que ce soit.

UbuWeb, et ses archives en ligne, ne pourraient exister sans Internet. Le projet lui-même est né juste après l’avènement d’Internet. Comment s’est-il adapté aux énormes transformations subies par le web au cours de ces dernières années, notamment celles des méthodes de partage et d’accès à des idées et des connaissances?

UbuWeb n’a jamais été dépendant de serveurs Cloud. Nos serveurs sont stables et transparents, ils nous ont été donnés par une école d’art de la ville de Mexico. Par conséquent, quand vous téléchargez quelque chose depuis UbuWeb, vous obtenez un fichier AVI ou MP3 sans échec, sans temps d’attente, sans paiement, sans captchas, toutes ces choses qui ont fait la fortune de Megaupload. Je plains tous ces gens qui ont construit de merveilleux blogs MP3 en croyant que Megaupload serait toujours là. Je peux comprendre ce qui les a poussés à le faire, mais dans la culture commerciale, il y a toujours un prix à payer. Rien n’est gratuit. Et pour les utilisateurs de Megaupload la facture a fini par tomber.

Quels sont vos rapports avec les archives institutionnelles aux États-Unis et partout ailleurs dans le monde ? Vous êtes vous déjà rencontrés et avez-vous déjà essayé de connaître la manière dont ils vous perçoivent ? Envisagez-vous des collaborations ?

Les seules archives institutionnelles avec lesquelles nous collaborons aux États-Unis sont PennSound et l’Electronic Poetry Center de l’Université de Buffalo. L’EPC est né à la même époque que nous et nous sommes partenaires depuis ce temps-là. PennSound est vraiment le pendant légitime et autorisé d’UbuWeb : une grande partie de nos documents sont stockés sur les serveurs de PennSound. Le genre de travaux auxquels UbuWeb s’intéresse n’est partagé que par un public très limité, par conséquent il n’y a pas vraiment de compétition ou de confrontation; personne ne semble les vouloir à part nous.

Au cours des dernières années, les archives audiovisuelles institutionnelles se sont principalement intéressées aux méthodologies et aux stratégies Internet de mise en œuvre de systèmes pour diffuser leur patrimoine en ligne; de nombreux projets sont nés ralliant les institutions européennes et nord-américaines pour créer de nouveaux réseaux et de nouvelles plates-formes. Il est rare que le contenu y soit en libre accès (un compte institutionnel ou un accès VOD sont requis), certaines institutions (comme le NiMK à Amsterdam) ont même récemment facturé les utilisateurs pour le visionnage. UbuWeb est tout à l’opposé : il est né en tant qu’archive, directement sur Internet, avec du contenu partagé en accès libre et a comblé un grand vide dans la diffusion du patrimoine audiovisuel international. Par conséquent, quelles sont les similitudes et les différences entre UbuWeb et les archives institutionnelles au niveau du processus de partage de fichiers en ligne ?

Étant donné que nous sommes indépendants, nous ne devons plaire à personne d’autre que nous-mêmes. Nous improvisons au fur et à mesure. La seule chose sur laquelle nous insistons est le libre accès pour tous, et j’ignore pourquoi ces institutions ne font pas la même chose, mais nous refusons de mettre des pare-feu sur quoi que ce soit. PennSound, qui est géré par l’Université de Pennsylvanie est une exception : ils ont une philosophie identique à celle d’UbuWeb. UbuWeb croit au partage de la culture et s’oppose au droit d’auteur et à l’argent. Nous n’avons rien à gagner et rien à perdre. C’est ça la liberté. Et cette utopie est beaucoup plus intéressante que toutes les œuvres ou contenus que nous pouvons héberger. Il s’agit vraiment de la mission secrète d’UbuWeb.

Parlons un peu des utilisateurs d’UbuWeb. Comment la plate-forme génère et aborde le dialogue et avec les utilisateurs ? Est-ce qu’une véritable communauté existe par le biais de retours et commentaires ? Avez-Vous déjà envisagé des événements en mode hors connexion, à l’exportation de contenu Internet, au partage de contenu à travers des réunions physiques ?

UbuWeb n’est pas une démocratie, c’est ce qui fait sa grande qualité. Nous croyons qu’à un moment où tout est disponible, ce qui compte c’est le filtrage et la sélection. Ainsi, il est très difficile d’obtenir que vos œuvres soient présentées sur UbuWeb. Tout passe par un examen approfondi avant d’atterrir sur le site. Si vous voulez de la démocratie, allez sur archive.org ou YouTube. Si vous voulez du communautaire, allez sur Facebook. Nous n’avons rien à voir avec une communauté. Encore une fois, nous ne cherchons à plaire à personne à part nous-mêmes et ne cherchons pas vraiment à savoir ce que les gens pensent de notre site. Pourquoi se tourner vers des réunions physiques dont la portée est insuffisante et limitée alors que nous avons à disposition Internet, le meilleur système de distribution qui soit ? Tout semble très bien fonctionner ainsi.

La création de méthodologies de migration de contenus sonores et audiovisuels — du format analogique vers le numérique — est opérationnelle depuis longtemps dans l’archivage de l’art médiatique/basé sur le temps réel. Quelles méthodes utilise UbuWeb pour numériser le contenu audiovisuel et sonore et pourquoi ? Des laboratoires ou des institutions de référence s’occupent-ils de cette étape pour vous ?

À l’heure actuelle, nous remettons surtout en ligne des choses qui flottent autour de groupes de partage de fichiers privés auxquels seul un petit nombre de personnes a accès. Nous agissons comme des Robin des bois, volant un petit groupe pour redistribuer au plus grand nombre. Il y a tellement de choses qui circulent, qu’il ne nous est plus nécessaire de copier de nouveaux supports, ce qui amoindrit ainsi le besoin de laboratoires, d’institutions ou d’argent.

Est-ce que vous avez des retours ou des commentaires de la part d’artistes sur la manière dont vous fonctionnez ? De nombreux projets de conservation considèrent la relation avec les artistes comme essentielle…

Non. Les retours et commentaires de qui que ce soit, y compris des artistes, ne nous intéressent pas. Si quelqu’un n’aime pas se ce qui se trouve sur UbuWeb ou la façon dont on procède, il est libre d’aller voir ailleurs ou mieux encore, d’en faire une meilleure version, personne ne l’en empêche. Nous ne nous intéressons pas non plus à la conservation de manière sérieuse. Une véritable institution comme le MoMA devrait s’occuper de la conservation. Ubu est une excentricité, une archive non fiable, basée sur un caprice et une intuition, c’est un wunderkammer, un passe-temps, une farce. Sa beauté réside dans sa fragilité, son aspect éphémère. Un jour, le MoMA ou tout autre organe officiel fera une version correcte d’UbuWeb et nous mettra ainsi hors service. Nous attendons ce jour avec impatience.

UbuWeb peut être considéré comme un modèle en ligne durable, même sans financement institutionnel, sans argent pour son fonctionnement et sans publicité. Mais, comme vous l’avez dit à plusieurs reprises, UbuWeb pourrait disparaître pour un certain nombre de raisons : le FAI pourrait couper votre accès, le soutien des universités pourrait se tarir ou de nouvelles lois sur la violation du droit d’auteur pourraient s’imposer. Le site Web serait-il alors amené à disparaître ? Ce serait une énorme perte pour le patrimoine audiovisuel qui rendrait vain le travail des collaborateurs, des partisans et des bénévoles de ces dernières années. À cet égard, avez-vous envisagé une différente tactique de survie pour l’avenir ? Peut-être pourrait-elle inclure le web 2.0 ou les nouvelles stratégies économiques du crowdfunding et de mise en réseau ?

Je préfèrerais fermer UbuWeb plutôt que mendier de l’argent ou avoir recours à un Kickstarter. Ce sera le moment de dire « adieu, on s’est bien amusés tant que ça a duré ». Le web est éphémère et les choses disparaissent tout le temps. Profitez d’UbuWeb tant qu’il est là et assurez-vous de tout télécharger maintenant ou vous le regretterez lorsque le site aura disparu.

Justement, concernant les violations du droit d’auteur, UbuWeb existe dans ce que vous appelez « la zone grise » : le contenu que vous publiez se situe en dehors du marché commercial et le marché lui-même ne semble pas intéressé. UbuWeb semble être la preuve de la manière dont le droit d’auteur et la piraterie ne sont pas liés aux lois gouvernementales, mais plutôt aux intérêts économiques relatifs à la diffusion et à l’accès de la culture en ligne. Ainsi, comment travaillez-vous et vivez-vous à la frontière instable entre contrefaçon et violation du droit d’auteur d’une part et intérêt du marché de l’autre ? Pensez-vous qu’UbuWeb puisse être considéré comme une erreur de système des nouvelles spécificités du concept de droit d’auteur professé par les lois actuelles ?

Nous ne sommes pas sur une frontière parce qu’il n’y a pas de marché pour les choses que nous diffusons. Si vous essayez de les publier, et beaucoup de gens l’ont fait — vous vous rendrez compte que vous allez perdre de l’argent et devenir aigri. La nature de ces œuvres implique leur libre circulation. Il est important de noter qu’il existe différents types d’économies. Lady Gaga possède une entreprise de plusieurs milliards de dollars. Elle serait folle de ne pas la protéger. UbuWeb respecte ces autres types d’économie, c’est juste qu’ils n’ont rien à voir avec ce que nous faisons. UbuWeb, comme la majorité de l’art, est une aberration, une cour des miracles, une exception à la règle; il n’est pas la règle elle-même et ne devrait jamais être confondu avec elle.

Interview par Claudia D’Alonzo & Marco Mancuso

publié dans MCD #68, « La culture libre », sept. / nov. 2012