La production architecturale contemporaine utilise un nombre croissant d’outils informatiques soumis à une prolifération constante de fonctions et d’allocations changeantes dans le processus du design. Au début des années 1990, les programmes de dessin à disposition n’étaient rien de plus qu’une transposition numérique de processus analogiques et leur accessibilité, leurs fonctions de modélisation et leur puissance de calcul restaient limitées.

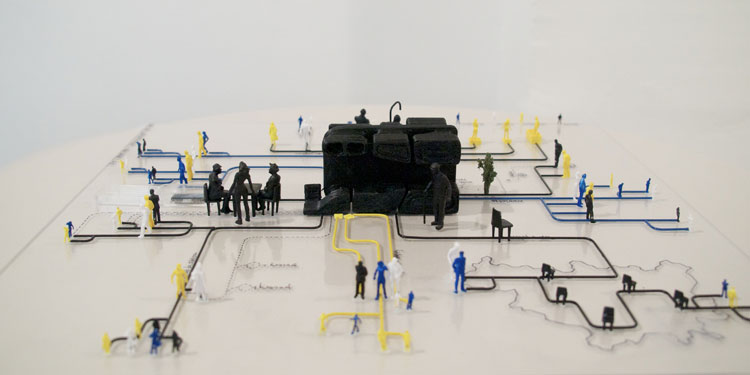

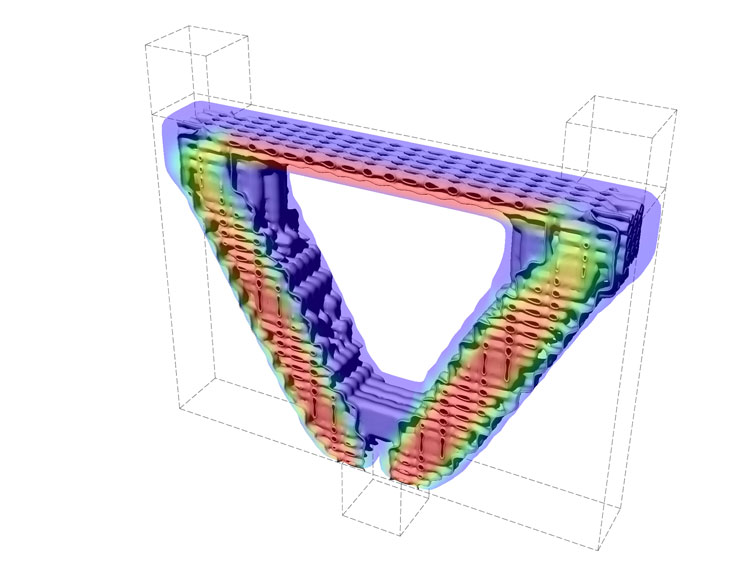

Solides cellulaires contrôlable paramétriquement basés sur une topologie optimisée et une pression principale, Daniel Buening / Professeur de Design Numérique et Expérimental. Palz – Université des Arts de Berlin

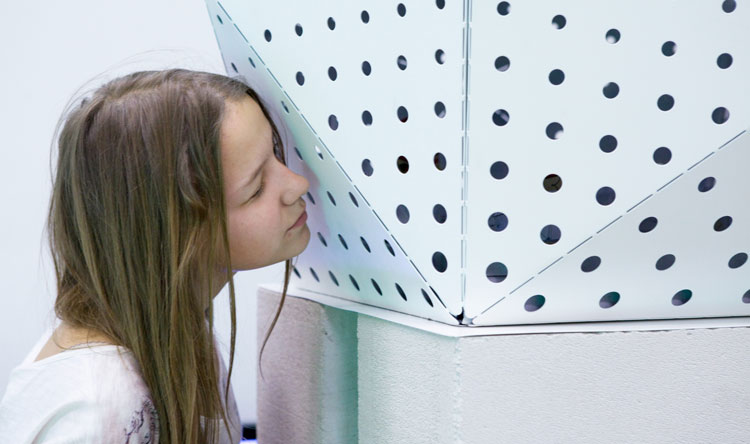

Aujourd’hui, les outils informatiques de l’architecture ont proliféré dans leur champ d’application et de fonctionnalités, complétés par des processus de fabrication contrôlés numériquement, étendant ainsi leur impact à la fabrication directe. La séparation initiale entre designer et fabricant, qui avait perduré à travers les siècles en architecture, a été modifiée par l’avènement d’un architecte qualifié en informatique et ayant accès à la technologie de fabrication. De nos jours, la fabrication assistée par ordinateur peut être contrôlée numériquement par les architectes et permet une mise en œuvre plus avancée de leurs concepts de design dans la construction, l’apparence et l’agencement des structures architecturales, des surfaces et des espaces. Par conséquent, est-ce que des matériaux plats, tels que des plaques d’acier ou des planches, économiques à découper au laser 2D ou au jet d’eau peuvent se transformer en volumes modelés et assemblés individuellement pour créer une expérience spatiale continue et curviligne… Expérience auparavant inconcevable sans l’intervention de l’ordinateur pour guider les procédés de fabrication : la répartition spatiale aurait été trop complexe et difficile à maîtriser. Similaires aux techniques de drapage utilisées en stylisme de mode (où un textile lisse est plié en une forme tridimensionnelle complexe), grâce à une interaction entre les éléments, la géométrie et la technologie, ces nouveaux modèles créent une apparence complexe dans l’espace. La fabrication de ces technologies qui complètent les opérations de design numérique peut être ici différenciée avec, d’une part, les processus de synthèse soustractive comme le fraisage 3-5 axes, la découpe au laser ou au jet d’eau, où la matière est soustraite d’un volume donné par un dispositif d’outillage et, d’autre part, des processus additifs, produisant une pièce par l’assemblage contrôlé de strates de matériau.

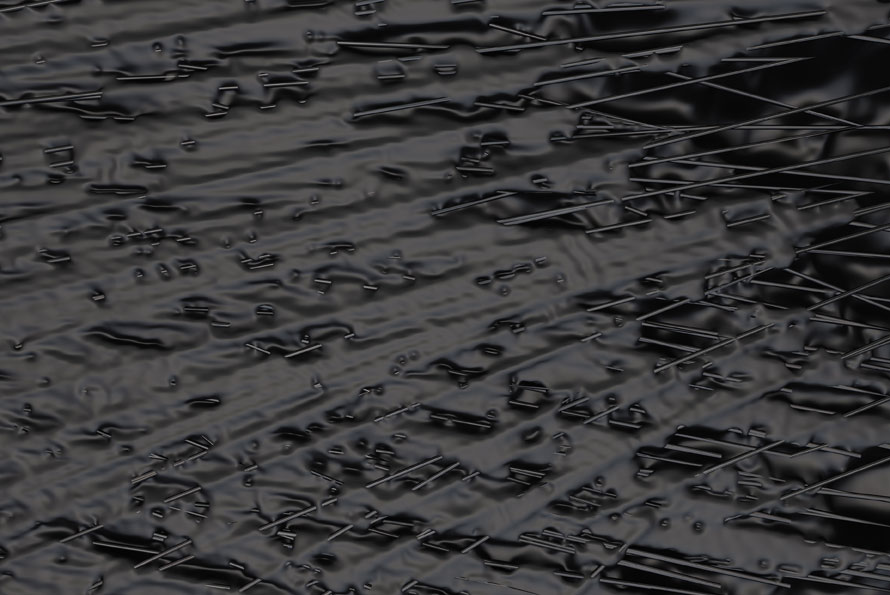

Les méthodes soustractives, qui découpent ou broient entièrement des couches de matériaux peuvent être interprétées comme l’amélioration d’un jeu d’outils traditionnels de travail sur les matières. Les technologies de fraisage s’apparentent à un processus automatisé de sculpture; la découpe guidée par ordinateur remplace ainsi le processus obsolète et laborieux de séparation des matériaux à l’aide de couteaux ou de lames. Grâce à la technologie, les caractéristiques historiques apportées par la réduction manuelle du matériel ont été prolongées, amplifiées et affinées par une précision mécanique plus détaillée, de plus grandes échelles, des cycles de production plus rapides et un plus large choix de matériaux, où l’homme a un rôle de contrôle et de design. La mise en œuvre de cette technologie en architecture s’étend au design ornemental des surfaces en trois dimensions, où les guides de la trajectoire de fabrication sont contrôlés d’un point de vue artistique et ajoutent une articulation affinée au matériau de surface en trois dimensions. Ainsi, la machine n’est plus seulement utilisée pour matérialiser un objet de design aussi précisément que possible, mais comme un nouvel instrument de façonnage architectural qui intègre son mode de production pour apporter une présence esthétique de l’objet ainsi créé.

À l’inverse, la fabrication additive est un terme collectif relatif à une série de procédés de fabrication novateurs qui permettent l’assemblage en strates verticales d’un contenu numérique en trois dimensions dans une large gamme de matériaux allant de polymères au plâtre en passant par les matériaux biodégradables, les alliages métalliques et autres matériaux. Le volume numérique destiné à être fabriqué par un tel procédé peut être d’une grande complexité géométrique, ce qui permet à des objets très détaillés d’être imprimés avec la même célérité que des figures géométriques simples, car le volume est construit par couches transversales de matériaux disposées verticalement dans un ordre chronologique. Les facteurs qui déterminent l’ampleur des détails réalisables sont uniquement définis par le processus de fabrication additif qui transmet l’information relative à la géométrie initiale, par sections, à la tête d’impression ou au faisceau laser qui fait fondre, fritte/agglomère ou colle les matériaux jusqu’à obtenir une forme stable. Cette indépendance de la géométrie et du temps de fabrication représente l’une des propriétés novatrices clé de cette technologie.

La courbe de progression de la technologie est abrupte. Les premiers processus industriels introduits par des systèmes 3D à la fin des années 1980 restaient à petite échelle et utilisaient des couches épaisses, mais il y a aujourd’hui de véritables améliorations dans les matériaux imprimés et dans l’échelle de la production globale. En 2008, la société Objet Geometries a introduit la technologie Connex qui permet la fabrication additive incluant jusqu’à quatorze polymères simultanés dans un processus de construction unique. Ces matériaux peuvent varier dans leurs propriétés élastiques ou leur translucidité et être assemblés pour la production de modèles aux propriétés haptiques (de toucher et de sensation) réalistes. À la même époque, Enrico Dini a développé le processus D-shape (D-forme) qui utilise une presse et des granulés de pierre naturelle pour fabriquer de manière additive des composants à l’échelle d’une construction pouvant atteindre jusqu’à 6m x 6m x 6m. Compte tenu du fait que la fabrication additive facilite grandement la matérialisation d’une complexité géométrique, l’importance des opérations géométriques informatiques sophistiquées s’est accrue au sein de l’activité du designer s’agissant de définir le sujet de tels procédés de matérialisation.

Drapé – Cronenberg #1. Norbert Palz / Daniel Büning / Photo: D.R.

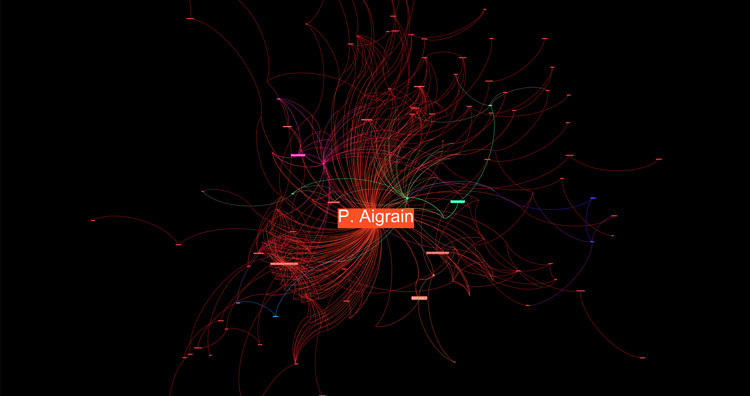

Le niveau d’abstraction induit par ces processus de modélisation ouvre amplement la voie à la mise en œuvre de pilotes de mise en forme d’une variété de sources entremêlées dans un code collectif et une morphologie géométrique, qui dépassent le cliché préconçu du designer. La structure de ces logiciels introduit une relation différente entre le designer et le design en modifiant l’étape où le façonnage pourrait être amorcé. Traditionnellement, la pratique du design suivait le protocole de la géométrie descriptive dans lequel l’architecte travaillait sur une série de dessins codifiés tels les structures élevées, les plans d’étages et les différentes sections pour aboutir à un design final. Il fallait opérer des changements de design dans chaque dessin individuel et le processus de représentation graphique lors de la phase de design rendait l’entreprise laborieuse. La pratique informatique contemporaine fonctionne toujours dans un espace tridimensionnel représenté sur un écran par une image en deux dimensions, mais les dessins en deux dimensions peuvent être extraits à souhait du modèle numérique. Les éléments géométriques du design sont, en outre, interconnectés paramétriquement, des modifications opérées sur un élément se reflètent dans l’apparence de l’autre. Si nous imaginons une grille en trois dimensions construite à partir de cubes ou de sphères, un programme de dessin géométrique classique nécessiterait une redéfinition de l’assemblage de la grille tout entière chaque fois qu’un changement général de l’un des éléments devrait se produire. Dans un modèle paramétrique contemporain, les différents paramètres qui définissent cette grille et les éléments qui en dépendent sont liés numériquement et peuvent être modifiés à volonté et, par conséquent, leur apparence tridimensionnelle est remise à jour en tant que réaction à un changement de la dimension initiale. Des problématiques concurrentes, comme les programmes, la performance environnementale et économique, ainsi que des entités moins évidentes comme la stratégie du design individuel, forment le processus de façonnage numérique et doivent être fusionnées en un système cohérent de relations géométriques.

La machine à géométrie construite par ces canaux de relations entrelacées interprète et modifie de façon dynamique les champs organiques de l’information qui dirigent clairement l’orientation du design. Ces paramètres peuvent recevoir des informations de façonnage issues de nombreuses sources, comme des assertions logiques codées ou des valeurs numériques récoltées dans les dépendances de mathématiques ou même des traductions numériques d’images employées à cet effet. Cette ouverture à de nombreux mécanismes de façonnage élargit l’amplitude du design architectural et artistique dans la mesure où les transpositions, interconnexions et ré-applications de facteurs de façonnage employés ont été facilitées. Cette règle simple définit le degré d’ouverture d’une façade selon le gain d’énergie solaire. La fonction du bâtiment peut ainsi suffire à déterminer la distribution progressive de dispositifs d’ombrage adaptés à chaque ouverture individuelle. Les changements sur ce design ne sont pas opérés sur un élément isolé du bâtiment, mais obtenus par une modification de la règle initiale qui entame une nouvelle itération du design. Ce processus, qui représente une dérogation importante au protocole géométrique euclidien dans lequel chaque élément d’un modèle est dessiné individuellement, mélange des mises en forme de différents types de données dans un tissu interconnecté d’origine artistique, mathématique et informatique. La complexité émergente apparente dans de tels designs développe les matérialisations entièrement pré-concevables, pragmatiques et rationnelles des époques précédentes et favorise les chevauchements géométriques et numériques qui apportent leur propre langue officielle et une nouvelle esthétique de l’irrégularité locale. Cette maitrise des contenus géométriques numériques extrêmement détaillés et irréguliers peut à présent être exploitée pour l’étalonnage local de matériaux et de composants de construction grâce au contrôle informatique de sa structure et de sa composition interne susceptible d’être conçu, analysée et plus tard fabriquée de manière additive dans une chaîne numérique unique. Mais quelles peuvent être les conséquences d’une telle matérialité numérique sur le processus de design architectural ?

Les progrès historiques de l’architecture et du design ont souvent découlé d’innovations dans la technologie de la construction et de la découverte de nouveaux matériaux. Cependant, leur mise en œuvre n’a pas toujours connu un succès immédiat. Les premières structures de génie civil créées après l’invention de la fonte au XVIIIe siècle appliquaient encore les principes structurels de la maçonnerie et des constructions en bois au lieu de tirer pleinement profit des propriétés structurelles du nouveau matériau ajouté au répertoire formel de l’architecture. Dans l’exemple classique du pont de Coalbrookdale (1777-79), on peut vérifier cette mise en application erronée en ce que les joints des éléments en fer ont été conçus comme des liaisons en bois et contiennent donc des composants inutiles sur le plan structurel. Il a fallu attendre de nombreuses années avant que le fer et l’acier révolutionnent le répertoire architectural grâce à leur structure légère et efficace comme on peut le constater dans le célèbre Crystal Palace de Joseph Paxton (1851). Plus tard, le béton armé a permis à de grandes structures étalées d’être construites avec des capacités simultanées de résistance à la pression et au poids comme le montrent, entre autres, les bâtiments pionniers de Pier Luigi Nervi et Eero Saarinen.

Design informatique de structures solides cellulaires à porosité graduelle contrôlable paramétriquement, Daniel Buening / Professeur de Design Numérique et Expérimental. Palz – Université des Arts de Berlin

La fabrication additive, par contraste, permet à un nouveau processus de design d’émerger, qui considère le matériau non pas comme une propriété homogène dont l’application traditionnelle serait basée sur des siècles de pratique et de répétition économique efficace, mais plutôt comme une constellation structurelle unique et variable de matières dans l’espace qui peut être conçue numériquement et s’est concrétisée à différentes échelles. Ces matériaux contiennent des propriétés structurelles en trois dimensions qui s’inscrivent dans le flux. La perspective de créer additivement des matériaux aux compositions internes et au choix de matières sur-mesure laisse envisager une contribution utile aux méthodes de fabrication contemporaines en termes d’efficacité structurelle, de réduction de la consommation de matériaux et de fonctionnalités innovantes et esthétiques des éléments créés en conséquence. La matière, la forme et la géométrie sont désormais intrinsèquement liées et peuvent développer une morphologie unique à chaque modification de leurs conditions limitatives.

Pourtant, dans l’architecture les questions théoriques naissent de ces potentiels, qui remettent en cause la notion traditionnelle du caractère et de la fonctionnalité des matériaux. L’étalonnage numérique guidé et la construction de nouvelles structures et formations envisagées ici modifient le dialogue historique sur la cohérence des matériaux, des structures et des formes présentes dans l’architecture depuis Aristote et Louis Kahn (entre autres). Il se peut donc que les designs architecturaux à venir soient fondés sur une solution structurelle mieux adaptée à un matériau donné avec des propriétés plus ou moins connues, mais il se peut aussi qu’à l’inverse un processus adapte un matériau approprié, doté de caractéristiques progressives uniques, à une forme ou une performance donnée. La complexité performative est alors atteinte non pas par le biais d’ensembles mécaniques complexes, mais à travers des matières localement différenciées. L’ordre constructif propre au Modernisme séparait les éléments des constructions par leurs fonctions hiérarchiques de support de charge et démontrait une rationalité et des dimensions qui débordaient souvent de l’échelle humaine.

Ce processus de construction séquentielle qui ajoute des couches de matériau était (et reste) responsable de la plupart des apparences historiques et contemporaines de l’architecture. L’enveloppe d’un bâtiment peut à l’avenir être transposée presque littéralement en associant les différentes couches de fonctionnalités individuelles à un élément de renforcement intégré, fabriqué a posteriori de manière additive. Ainsi, l’adoption éventuelle de plusieurs fonctions de construction dans un tel composant de construction unique peut s’enrichir de connaissances scientifiques relatives à la biologie et à la botanique. Les structures osseuses spongieuses qui modifient leurs morphologies cellulaires en fonction d’une charge spécifique forment un exemple tout à fait transposable par un processus informatique. Un bloc de construction cellulaire adapté, composé d’éléments géométriques fondés sur une base de données numériques pourrait être présenté parallèlement à l’analyse informatique des pressions ou des forces envisageables et fournir une morphologie définie localement et axée sur une performance juste et précise. La modulation d’éléments morphologiquement différenciés pour un objectif partagé, structural, logistique ou esthétique introduit un changement d’échelle et accorde de la valeur à la localité et à la différence individuelle, encourageant une perception simplifiée et moins hiérarchique de cette construction tectonique.

De telles unités modulaires de construction intégrées qui doivent être assemblées dans un nouveau mode de construction auront inévitablement une incidence sur la présence de l’architecture et établiront ainsi un nouveau langage de construction et d’ordre fonctionnel basé sur une nouvelle séquence d’assemblage structurel. Ces structures complexes peuvent, d’une part, être transposées à des éléments de construction classiques comme les murs, les toits et les colonnes et, d’autre part, initier une typologie nouvelle et sans précédent de composants architecturaux où le rôle de l’articulation qui associe ces éléments revêt une importance et une présence nouvelles. Ces éléments se prévalent de différentes manières des propriétés de la fabrication additive et peuvent offrir des résultats morphologiques sans précédent qui introduisent une nouvelle variation et une échelle humaine dans les éléments de construction. Grâce à l’intégration d’avantages propres à la fabrication additive, un nouveau langage tectonique autonome peut évoluer jusqu’à transformer de manière radicale notre pratique traditionnelle de l’architecture.

Norbert Palz

publié dans MCD #68, « La culture du libre », sept. / nov. 2012

Norbert Palz est professeur en Design Numérique et Construction à la Muenster School of Architecture et à l’Academy of Art de Berlin (UdK) où il occupe la Chaire de « design numérique et expérimental » dans la section Architecture.