la réussite des technologies mises au service du développement local

Les technologies de l’information et de la communication (TICs) prennent une place toujours plus importante dans notre quotidien, mais cette intégration se heurte à un ensemble de contraintes auxquelles, le plus souvent, on accorde trop peu d’importance. L’utilisation en Afrique des technologies des pays développés ne peut se faire sans une prise en compte de notre écosystème, des réalités socio-culturelles et des besoins des populations locales. Ainsi, l’innovation sera nécessaire, non pas dans le sens de recréer des technologies déjà existantes ailleurs, mais en adaptant ces dernières à nos réalités, afin de produire des solutions utiles pour le développement local.

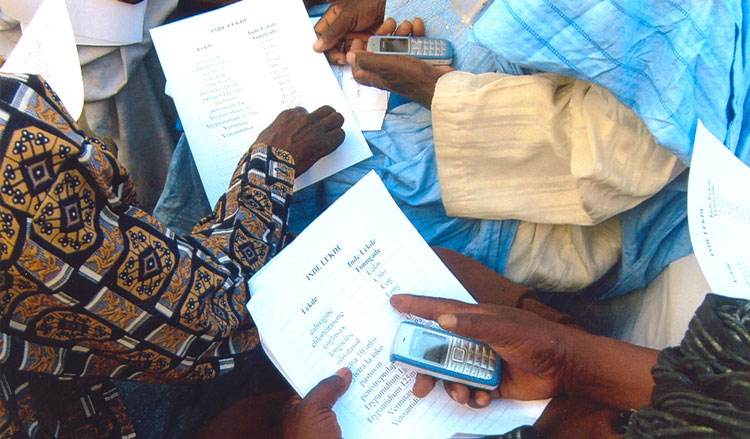

Acacia-CRDI. Simulation avec des étudiants en zone rurale. 2007. Photo : © Moussa Déthié Sarr.

Au fil des années, les TICs se sont imposées dans nos pays d’Afrique subsaharienne, facilitant l’accès à l’information, haussant la productivité des entreprises et de l’administration, permettant un renforcement de l’éducation dans l’enseignement supérieur, et améliorant des gestes dans le domaine de la santé. Cette adoption des TICs est surtout possible grâce à un certain nombre d’outils principalement orientés dans le domaine de la communication, tels que les solutions logicielles, Internet, les réseaux et terminaux mobiles.

Mais il faut noter que cette appropriation des TICs est beaucoup plus orientée vers le milieu urbain et surtout les populations alphabétisées. Selon l’Institut de statistiques de l’UNESCO, 58% de la population sénégalaise vit en milieu rural et, sur le total de la population, on compte 49,7% d’analphabètes chez les adultes et 65% chez les jeunes. Donc, il est devenu plus que nécessaire de prendre en compte les zones rurales et les populations illettrées dans l’intégration des TICs en Afrique subsaharienne. À cela s’ajoute un écosystème des TICs qui présente des limites en termes de connectivité Internet : les coûts élevés des moyens et outils de communication par rapport aux revenus des populations locales. Nous pouvons prendre l’exemple de la connexion Internet qui, pour un débit 16 fois plus élevé, est vendue moins cher par Orange France que par Orange Sénégal (8 Mo à 21 € contre 512 Ko à 22,14 €).

Face aux obstacles socio-culturels et technologiques, il sera impératif de partir du besoin des populations locales, avec prise en compte de ces contraintes, pour que soit menée une bonne politique d’intégration des TICs. Cette politique pourra ainsi se baser sur le concept des technologies au service du développement ou « ICT4D », l’acronyme anglo-saxon (1). Le concept d’ICT4D repose sur la théorie que les TICs favorisent le développement d’une société. En plus de leur rapport aux TICs de manière générale, les ICT4D requièrent une compréhension du développement communautaire, de la pauvreté, de l’agriculture, du secteur de la santé et de l’enseignement de nos pays en voie de développement. Les ICT4D ont connu une progression fulgurante ces dernières années en Afrique grâce aux financements obtenus. Mais selon la chaire de l’Unesco en ICT4D, la plupart des initiatives de TICs implémentées en Afrique échouent.

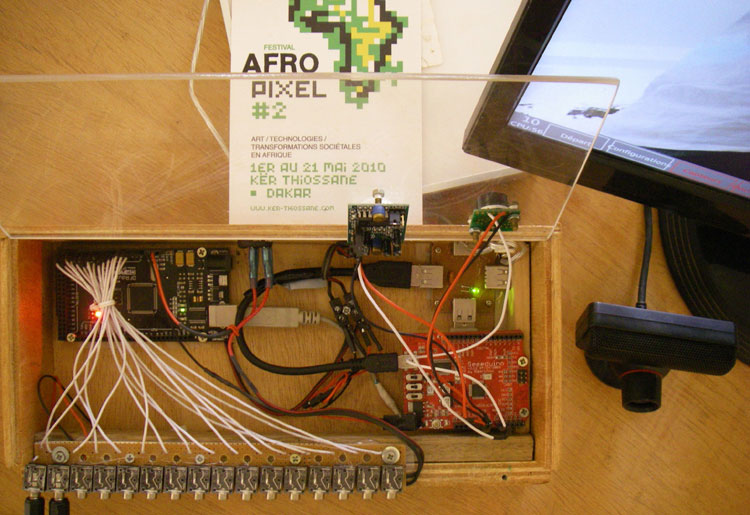

Les TICs pour l’agriculture (3ème photo du concours Elearning Africa, 2012). Solution mobile pour l’agriculture. 2011. Photo : D. R.

Selon une étude menée par les chercheurs du projet Edulink-Alanga, à l’Université d’Eastern Finland, les causes de cet échec sont diverses. Cependant, la première d’entre elles réside dans le montage de projets qui ne sont pas réalisés aux bons endroits, c’est-à-dire dans des pays où les défis et les besoins locaux des populations cibles ne sont pas suffisamment maîtrisés pour être pris en compte par de tels projets. En effet, la non-implication des populations concernées par la conception et la restitution des outils et services des TICs qui leurs sont destinés constitue un facteur bloquant dans le processus d’appropriation d’un outil TIC. Parmi d’autres causes de cet échec, il faut citer le manque d’évaluation de l’impact économique de ces outils et services sur les activités économiques quotidiennes des populations. Ces différentes observations amènent à soutenir la thèse que l’unique moyen de mener à bien les projets ICT4D est de passer par une innovation technologique contextuelle aux milieux concernés. Cette Innovation reposera sur des bases simples, telles que la prise en compte des besoins des populations, de l’impact économique et de l’écosystème des TICs, qui, quand ils sont négligés, conduisent à l’échec des ICT4D.

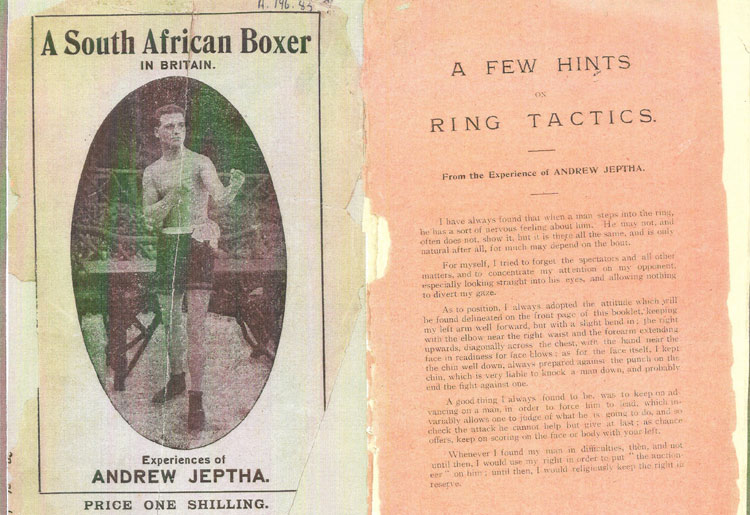

Le sens de l’innovation technologique ne réside pas dans une nouvelle invention de la roue, mais plutôt dans sa réadaptation à nos besoins dans le cadre des ICT4D. Cette innovation technologique ne doit pas être perçue comme un concept compliqué, car son essence même réside dans la simplicité des solutions. Très souvent, les populations ciblées ont des besoins simples, tels que l’accès à l’information; nous pouvons citer aussi l’exemple du système d’information géographique (SIG), développé dans le cadre du projet Acacia à la Faculté des Sciences et Techniques de l’Université Cheikh Anta Diop de Dakar (UCAD), en partenariat avec le CRDI (Centre de Recherche pour le Développement International). Dans ce projet il a été mis en place un SIG mobile pour la gestion des ressources pastorales au niveau des unités de Thiel et de Kouthiaba, au Sénégal. Cette application avait permis aux éleveurs d’avoir une information en temps réel de l’état des points d’eau et des chemins appropriés pour la transhumance, à partir d’un système de communication basé sur les SMS.

Ainsi, partant d’un besoin simple des populations et capital pour la survie du bétail, une solution basée sur des médias à faible coût, tels que SMS et téléphones, a été mise à la disposition des populations locales, après qu’elles ont été fortement impliquées dans le processus de conception et de déploiement. Il nous faut préciser que si les besoins des populations locales peuvent être similaires à ceux des pays développés, les méthodes utilisées pour y subvenir doivent être remodelées dans la pratique. La monétique est l’un des secteurs qui illustre le mieux ces besoins communs et, au Sénégal, le service Orange Money, de l’opérateur de télécommunications, permet à partir d’un compte créé avec un mobile de faire, en tous lieux, des dépôts d’argent, des transferts aux proches, la consultation du solde, des paiements de factures, le remboursement d’une échéance de prêt micro-crédit, et le débit d’argent. Cette méthode innovante permet, par des gestes simples, de faciliter le quotidien des populations locales avec uniquement un téléphone portable, qui est le support de communication le plus utilisé dans toutes les couches sociales et toutes les classes d’âges.

Acacia-CRDI. Tests réalisés par des utilisateurs sur l’application Magasin de bétail pour réserver des produits. 2007. Photo : © Babacar Ngom.

Prendre en compte l’écosystème des TICs de nos pays dans la recherche de solutions ne peut qu’être source d’innovation technologique, sachant que des problématiques comme la connectivité Internet n’existent pas dans les pays développés. Dans cette optique, des travaux de Recherche et Développement, menés dans le cadre d’un partenariat entre la Coopération française U3E et le Centre de Calcul Informatique de l’UCAD, ont abouti à la mise en place d’une solution de suivi des formations en ligne en utilisant un mode déconnecté, pour pallier ce problème d’accès à Internet et permettre la réduction des coûts à travers la réduction de flux. Un système de notification par SMS intégré à cet outil facilite la communication d’informations aux étudiants. Un parfait modèle de prise en compte de l’écosystème des TICs pour leur intégration dans le secteur de l’enseignement (acronyme : TICE, TIC pour l’Éducation).

Le défi de l’intégration des TICs en Afrique subsaharienne repose principalement sur la nécessité de dépasser les limites socio-culturelles, économiques et technologiques pour en faire un rempart solide du développement local. Le recours à l’innovation technologique sera un moyen incontournable, face à ces limites, pour mener à bien des stratégies ICT4D efficaces. Une remarque particulière peut être faite sur les terminaux mobiles qui illustrent l’innovation technologique. L’usage du mobile par toutes les couches sociales et classes d’âges, implique qu’un intérêt particulier doive être porté sur les solutions qui l’utilisent, si l’on veut toucher une partie importante des populations. Une bonne politique ICT4D ne peut être menée sans la prise en compte des besoins et contraintes locales, et sa réussite est assurée lorsqu’elle est mise en œuvre par les populations locales pour les populations locales, et là réside toute l’essence de l’innovation technologique.

Babacar Ngom

publié dans MCD #71, « Digitale Afrique », juin / août 2013

Babacar Ngom est ingénieur Informaticien au Centre de Calcul Informatique de l’UCAD. Chef de la Division Elearning. Responsable de projets Recherche & Développement

(1) ICT4D : Information and Communication Technologies for Development, les TICs au service du développement.

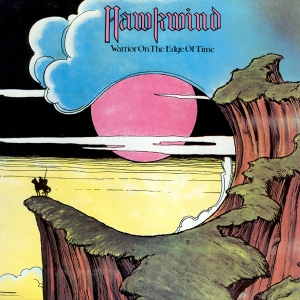

Mais c’est du côté de la musique psychédélique que la composante SF est la plus prégnante dans l’optique évoquée par Norman Spinrad. Avec en première ligne le vaisseau spatial des Pink Floyd piloté par Syd Barrett qui délivre des titres crépitants d’étoiles et fleurants bon l’acide et la marijuana comme Astronomy Domine, Interstellar Overdrive, ou Set the Control for the Heart of the Sun, et toute la constellation « Krautrock » (rock allemand des années 60/70) avec les représentants emblématiques du courant « cosmiche musik » : Tangerine Dream (Alpha Centauri, Phaedra, Rubycon, Stratosfear), ou Klaus Schulze (Cyborg, Timewind, Moondawn, Dune) aux titres d’albums évocateurs d’immensités intersidérales sillonnées par des cargos interstellaires, et de planètes plus ou moins exotiques qu’un Gustave Holst a déjà célébré en son temps. Mais là où la musique du compositeur anglais ne fonctionne à plein rendement sur le plan de l’illustration sonore qu’une fois la thématique énoncée, il suffit de quelques notes aux cosmiche rockers allemands pour nous propulser dans l’espace.

Mais c’est du côté de la musique psychédélique que la composante SF est la plus prégnante dans l’optique évoquée par Norman Spinrad. Avec en première ligne le vaisseau spatial des Pink Floyd piloté par Syd Barrett qui délivre des titres crépitants d’étoiles et fleurants bon l’acide et la marijuana comme Astronomy Domine, Interstellar Overdrive, ou Set the Control for the Heart of the Sun, et toute la constellation « Krautrock » (rock allemand des années 60/70) avec les représentants emblématiques du courant « cosmiche musik » : Tangerine Dream (Alpha Centauri, Phaedra, Rubycon, Stratosfear), ou Klaus Schulze (Cyborg, Timewind, Moondawn, Dune) aux titres d’albums évocateurs d’immensités intersidérales sillonnées par des cargos interstellaires, et de planètes plus ou moins exotiques qu’un Gustave Holst a déjà célébré en son temps. Mais là où la musique du compositeur anglais ne fonctionne à plein rendement sur le plan de l’illustration sonore qu’une fois la thématique énoncée, il suffit de quelques notes aux cosmiche rockers allemands pour nous propulser dans l’espace. Cette musique que nous ne percevons pas, mais qui existe quelque part dans l’univers mathématique du monde, ne l’entendons-nous pas d’une certaine manière dans la B.O. d’Eraserhead « interprétée » par David Lynch & Alan Splet ? Cette réinvention d’une musique de la matière, du temps et de l’espace me paraît être, selon la définition de Norman Spinrad, incontestablement une musique de science-fiction, tout comme les images qui vont avec.

Cette musique que nous ne percevons pas, mais qui existe quelque part dans l’univers mathématique du monde, ne l’entendons-nous pas d’une certaine manière dans la B.O. d’Eraserhead « interprétée » par David Lynch & Alan Splet ? Cette réinvention d’une musique de la matière, du temps et de l’espace me paraît être, selon la définition de Norman Spinrad, incontestablement une musique de science-fiction, tout comme les images qui vont avec.