Un manifeste

De la science cinétique à la science sensible… Depuis la création du Laboratoire d’Hydrodynamique (LadHyX) du CNRS et de l’École Polytechnique, Jean-Marc Chomaz s’est investi comme chercheur et artiste dans des projets « Arts et Sciences » en collaboration avec des artistes de toutes les disciplines (cirque, théâtre, design, art contemporain, musique…). Son approche tente de donner directement accès à un imaginaire utilisant le langage et les concepts scientifiques non pour faire preuve, mais pour faire sens.

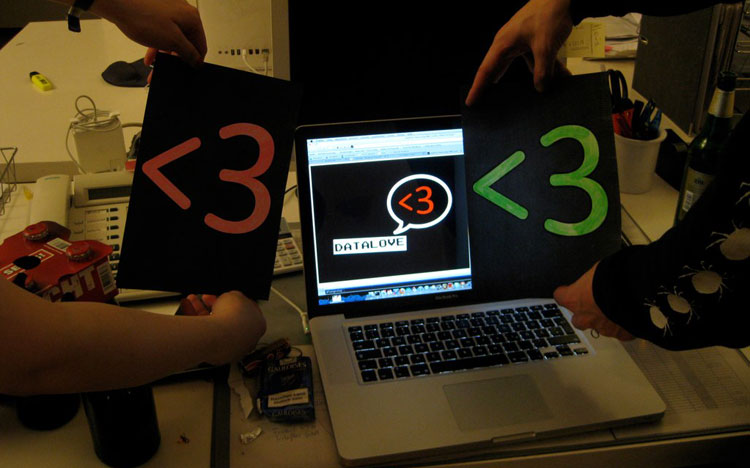

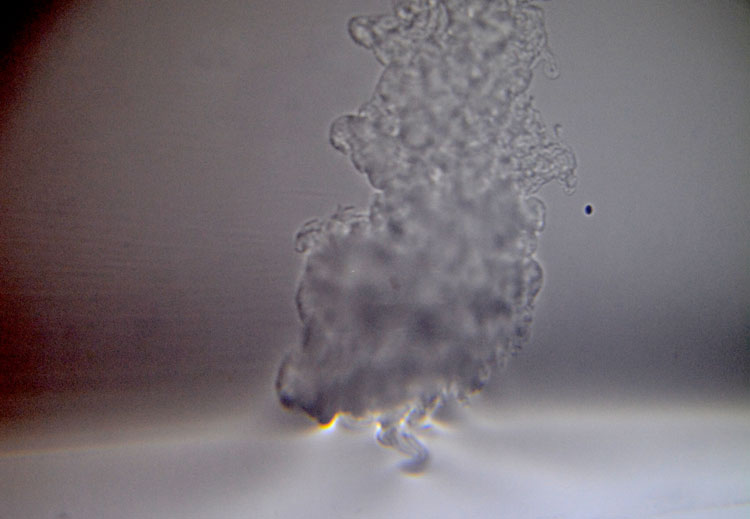

Gouttes d’oxygène liquide devenues tangibles dans l’installation 2080, présentée dans le cadre de l’exposition Aquaplanet de Labofactory, Zone2Source, Glazen Huis, Amstelpark Amsterdam 31 mai / 23 août 2015, qui a reçu le label Our Common Future Under Climat Change de COP21. Photo: © JMC.

D’où vient cette conviction intime que les politiques de popularisation des sciences actuelles font fausse route ? D’où vient ce sentiment d’urgence absolue qu’il ne faut plus être pédagogique et tenter de communiquer les avancées des sciences en glorifiant ses réussites, mais au contraire que nous autres scientifiques devrions révéler notre face cachée, faite à la fois de ténèbres et de sublime, celle que nous ne maîtrisons ni même ne comprenons, mais qui est à l’origine des vrais progrès scientifiques ? Il nous appartient d’abandonner le soliloque afin de permettre au public d’inventer son chemin, sa découverte, de s’approprier et de raconter l’histoire ainsi, renversant le flux habituel, d’apporter son ressenti son expérience à la science et de venir l’enrichir, cessant d’être ainsi un simple réceptacle inerte pour partager et contribuer au questionnement scientifique.

Les travaux que j’ai réalisés conjointement avec d’autres artistes comme le duo HeHe, Anaïs Tondeur ou encore au sein du collectif Labofactory fondé avec Laurent Karst et François-Eudes Chanfrault (1), n’ont pas pour but de montrer ou démontrer des phénomènes scientifiques, d’asséner des preuves formelles ni d’inviter le public à se joindre à un voyage scientifique lui révélant des faits établis. Ils suggèrent plutôt un point de vue différent, une transgression déstabilisante, une comparaison inconfortable, une expérience corporelle, une métaphore de la physique qui utiliserait l’imagination scientifique pour réinventer notre perception du monde et interroger la vérité dans sa relativité et dans toute sa fragilité.

Aquaplanet, imaginer la planète océan

Dans l’installation Fluxus de Labofactory, de fins bassins à vagues transparents sont perçus comme des tambours mous et silencieux. Le récit artistique devient alors une partition orchestrée par les propriétés physiques des cymbales, leurs résonances, leurs attaques et leurs vibratos, construisant une fantaisie visuelle par le biais de leur matérialité inversée, associant la transparence de l’eau avec la brume froide, seule matière visible s’élevant dans les airs au-dessus de l’interface. Avec ce collectif nous avons créé en mai 2015 l’exposition Aquaplanet à Amsterdam (2). Aquaplanet est une abstraction scientifique, une planète entièrement recouverte d’eau sans continent, sans relief même sous-marin, juste les vagues et le vent. Une fiction qui permet d’interroger la ronde rugissante de l’atmosphère et de l’océan, l’étonnante complexité d’une épure dans l’imaginaire de silicone de nos machines.

L’exposition Aquaplanet est un manifeste, un territoire d’invention à la fois sensible, familier et étrange. Elle est habitée des tempêtes de l’installation Fluxus qui transforme Amstelpark en navire traversé des vagues gravitationnelles de la maison de verre. Elle nous dit la fragilité de l’atmosphère par l’installation performance 2080, où l’oxygène de l’air devient tangible. Dans l’installation Red shift de Labofactory, nos ombres que l’expansion de l’Univers décale vers le rouge renoncent aux aplats de lumière, noires surfaces découpées qui revendiquent les quatre dimensions et se placent fièrement entre le soleil et sa proie. Elles flottent dans l’espace comme des lambeaux de ciel abandonné des astres. L’installation Red shift permet à nos sens de percevoir la course de notre planète à travers les dilatations de l’espace-temps, fantôme d’éolienne générant le vent solaire. Elle figure aussi les souffles de l’air d’une atmosphère où s’impriment les ombres des créations anthropiques.

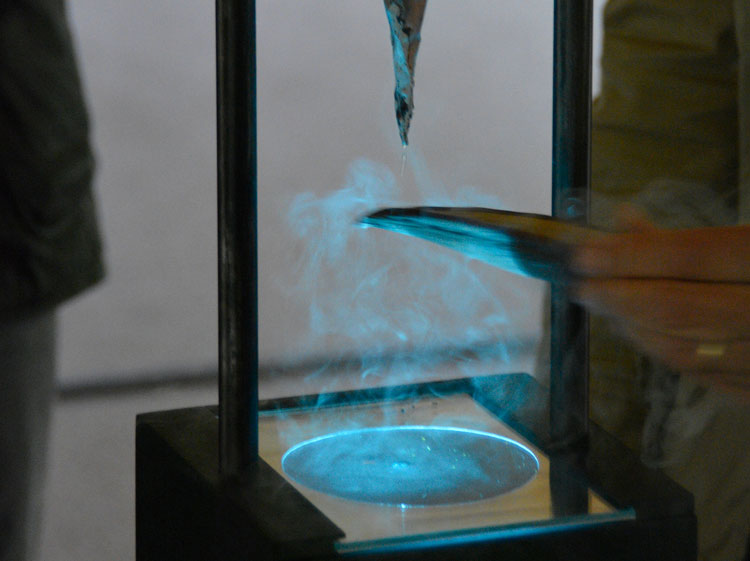

Catastrophe domestique n° 3 : La Planète Laboratoire, installation créée en collaboration avec HeHe, un jouet, un globe terrestre tournent dans un réservoir ressemblant à une installation scientifique. À intervalles réguliers, un nuage vert fluorescent apparaît, atmosphère ténue qui se répand du pôle à l’équateur avant de s’évanouir dans l’éther liquide avec lequel elle se confond. Bien que les phénomènes physiques à l’œuvre dans la maquette du globe ne correspondent à rien de similaire à l’échelle de la planète, la métaphore opère.

Catastrophe domestique n° 3 : La Planète Laboratoire, installation créée en collaboration avec le duo d’artistes HeHe (Helen Evens & Heiko Hansen) présentée à l’exposition Carbon 12, espace Electra, fondation EDF Paris, 2012. Montage Photo: © JMC.

La disparition d’une île

L’exposition Lost in Fathoms présente le résultat de recherches partagées et menées pendant plus d’un an au LadHyX avec un ensemble d’installations interrogeant la lithosphère et l’océan (3). La Machine à tremblements de terre, sous l’action constante répétée à l’infini du glissement d’une plaque tectonique, une pierre de basalte effectue des mouvements soudains imprévisibles. Les deux forces dont la brisure d’équilibre provoque le glissé, la friction et la déformation élastique du milieu ont été dissociées par l’ajout d’un champ magnétique permettant de libérer la pierre de l’emprise du réel. Cette hésitation entre tremblements et stupeur est transcrite par une écriture de soubresauts, mystérieuse et chaotique qui en devient presque surréaliste. Le titre de l’installation pourrait être aussi Champs Magnétiques, l’écriture automatique des roches tectoniques pour faire référence à la publication d’André Breton et Philippe Soupault Champs Magnétiques expérimentant à deux les techniques d’écriture automatique libérant l’inconscient comme en réponse aux blessures indicibles de la guerre.

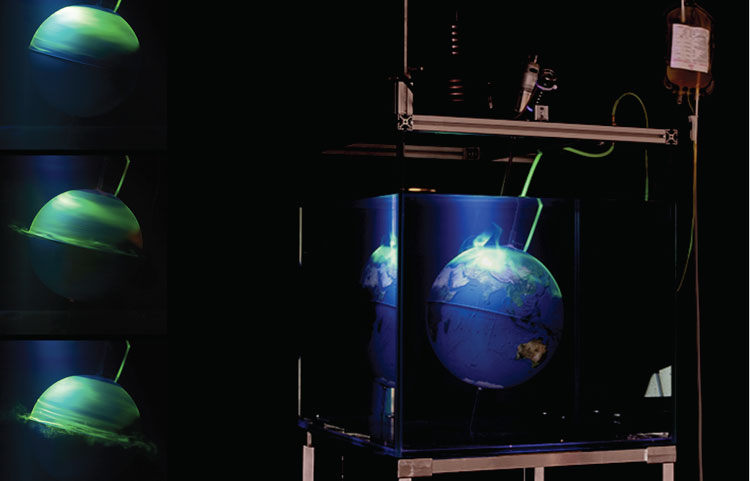

Ici les forces telluriques semblent avoir pris forme en un récit automate qui interroge la légitimité de l’homme, à se proclamer force façonnant la planète. Un peu comme si les rochers dans le lointain d’un tableau de Dali se mettaient à bouger et exprimer la persistance de la pierre. Un peu plus loin, l’installation La dernière vague de la MOC, présente un océan parallélépipédique dans lequel l’eau profonde se forme régulièrement et finit par sombrer, mélangeant infiniment lentement toute l’eau contenue et, ce faisant, ralentissant la circulation thermohaline océanique réelle vers un nouvel événement anoxique. La variation de densité, les turbulences et les mouvements des vagues dans le liquide sont soulignés par des ombres sur les murs de la galerie, et le visuel continue à évoluer au fil des semaines tandis que les eaux se mélangent, jusqu’à disparaître complètement : au terme de l’exposition, l’eau contenue dans le réservoir étant devenu complètement homogène.

Ces aventures partagées avec des artistes aux démarches et aux interactions extrêmement diverses et venues de parcours de recherche bien distincts m’ont amené à réaliser, cependant, que celle-ci est étroitement liée à une signification et à un engagement plus profonds. L’espèce humaine qui, à l’échelle géologique, aurait dû rester un événement éphémère et marginal se voit confrontée à une menace mortelle directement liée à sa propre action et à son utilisation désinvolte, dénuée de verbalisation et de remise en cause, de la science et de la technologie. La fascination exercée par la science sur l’esprit de tout un chacun, à commencer par les scientifiques eux-mêmes, reste extrêmement puissante, comme l’atteste la couverture médiatique de l’observation probable du Boson de Higgs : elle a donné une tribune à la science et changé la pensée critique en permafrost. La science a donc besoin d’être réenchantée, réinvestie par l’humain, afin de permettre à de nouvelles histoires d’émerger en pensée et en parole et de constituer une « chanson de geste » moderne, entièrement consacrée à des actions durables à l’échelle planétaire et à l’émergence de chemins de pensée éthiques, globalement assumés.

La toute-puissance scientifique et la foi à tout crin de la science dans le progrès font désormais partie de discours du XIXe et XXe siècles : lequel appartient à des certitudes d’un autre âge, dont la voix qui s’efface nous invite à reprendre le cours de l’histoire. De nos jours, les avancées scientifiques sont souvent perçues davantage comme une menace que comme un progrès. Les scientifiques commencent à comprendre que la science et l’approche scientifique elle-même sont peut-être impuissantes à résoudre, voire à appréhender la réalité et la signification de, par exemple, l’évolution du climat ou les nouvelles frontières que constituent aujourd’hui les questions de la vie et de la conscience.

Projection physique de 5 mètres de diamètre de La dernière vague de la MOC capturée dans un océan de laboratoire de 1,2x06x0,7m3, installation réalisée lors de l’exposition Lost in Fathoms de Anaïs Tondeur et Jean-Marc Chomaz, présentée à laGV-Art Gallery à Londres en 2014. Photo: © JMC.

Penser un nouveau pacte pour l’anthropocène

Une grande partie de ma recherche scientifique et de mes travaux associant l’art et la science ont pour objet la question du changement climatique, et plus précisément comment prévoir, analyser, mais aussi appréhender la portée, dans l’état des connaissances actuelles, de la notion d’anthropocène; l’usage controversé de ce terme, qui à lui seul fait office de manifeste, remet en question l’impact et l’éthique de l’homme et exige un engagement tant individuel que collectif en vue de la définition et de la construction d’un nouveau pacte, un new deal actualisé et partagé.

De tels problèmes et défis globaux échappent à la seule sphère de la science, laquelle est conçue pour fractionner un problème complexe et délicat en plusieurs petits systèmes isolés, jusqu’à atteindre un stade où la question peut faire l’objet d’une expérience de laboratoire, d’une étude informatique ou d’une modélisation dans le cerveau d’un scientifique. La science n’a jamais été pensée pour reconstruire le système fragile et complexe dans son ensemble.

Il nous faut un protocole différent, une autre approche et un nouveau schéma d’analyse pour aborder les défis que posent les phénomènes multiples, complexes et transdisciplinaires imbriqués dans le concept d’anthropocène. Une pensée globale, ou plus précisément une vision syncrétique qui, à l’instar de la perception intuitive globale des jeunes enfants, s’est vue effacée par la pensée rationnelle régnant dans l’enseignement institutionnalisé qui se contente de fractionner une question légitime en sous problèmes rigoureux et sans valeur. Dans le domaine artistique, une telle représentation syncrétique (non fragmentée) du réel a été explorée par les cubistes, qui ont cherché à apprendre à dessiner comme un enfant, mais dans le domaine scientifique, la question de savoir comment acquérir et développer une vision plus intuitive, plus globale, reste inexplorée et n’a même pas été formulée.

Le principe de précaution, adopté pour la première fois par les Nations Unies en 1982 en même temps que la Charte mondiale de la nature, est conçu pour traiter de problèmes trop complexes pour que la science puisse leur trouver de solution en l’état actuel de nos connaissances, et prendre des décisions sans la certitude de faits scientifiquement établis. Ce principe est extrêmement difficile à appliquer, car pour parvenir à une stratégie, il faudrait au moins trois ingrédients actuellement absents : établir les statistiques de l’incertitude due à la fois à notre ignorance actuelle du système et de la variabilité intrinsèque des mécanismes physiques impliqués, quantifier et mesurer les dangers potentiels (espérance de perte) ainsi que les actions à entreprendre (fonctions de coût).

Dans l’éventualité qu’une telle stratégie voie le jour, nous manquerions encore de moyens pour l’imposer aux gouvernements et aux populations qui réévalueraient cette politique à l’aune de leurs intérêts propres. Plus précisément, les réponses apportées aux problèmes cruciaux soulevés par l’ère nouvelle de l’anthropocène exigeraient certainement des modifications radicales de comportement qui ne pourraient pas être obtenues par la seule pédagogie, le niveau d’action nécessaire ne pouvant être atteint qu’avec la conviction et l’implication de tous.

Recherches en Laboratoire au Department of Applied Mathematics and theoretical Physics avec les étudiants de la Summer School Fluid Dynamics for Sustainability and Environment réalisées dans le cadre du projet Lost in Fathoms de Anaïs Tondeur et Jean-Marc Chomaz. Photo: © JMC.

Afin d’aborder des problèmes aussi complexes, notre vision doit non seulement se faire syncrétique, mais aussi globale, c’est-à-dire qu’elle doit être défendue et partagée par un groupe extrêmement large d’êtres humains. La signification donnée au mot anthropocène et la nature même de l’ère à venir seront le fruit de toutes les histoires et actions humaines, individuelles et collectives, que nous entreprendrons en réponse à cette représentation et à cette verbalisation de la trajectoire de l’humanité. Mais la science seule ne peut pas produire une telle vision.

La science n’est qu’un protocole abstrait et spécifique : afin d’intégrer des observations récentes, elle propose de nouveaux modèles mathématiques hautement idéalistes, et en essence extrêmement limités, puis en tire de nouvelles prévisions qu’elle confronte à de nouvelles mesures jusqu’à ce que le modèle ne corresponde plus aux observations, et recommence tout à zéro. Enfermée dans un tel protocole de la preuve, la science semble éternellement condamnée à passer de modèles incomplets à des modèles inconsistants ou incohérents, sans aucun espoir de ne jamais atteindre ce qu’on pensait être autrefois la vérité en attente de révélation : Gödel l’a démontré, dès les années 30, pour un ensemble de problèmes dans ses fameux théorèmes d’incomplétude (4).

Le discours scientifique est donc de prétendre que le modèle lui-même est une représentation du monde, sans se soucier du fait que la science ne sera jamais en mesure de décrire complètement la dynamique de ce modèle (par exemple, le fait d’imaginer l’univers comme un ensemble de particules élémentaires n’apporte aucun éclaircissement, même à un niveau statistique, puisque le procédé qui réconcilierait l’infiniment petit et l’infiniment grand restera toujours à inventer, en particulier pour les systèmes hors équilibre). La science ne sera pas davantage à même de valider le modèle (du fait de l’extension du théorème d’incomplétude) ni d’établir un modèle pour des systèmes complexes mis en interaction comme dans la dynamique du climat, car d’une part, elle manque de modèles partiels (comme dans le cas de la cryosphère) et d’autre part, les couplages de sous-systèmes restent encore à déterminer (même pour des quantités simples telles que les flux de chaleur entre la cryosphère, les océans et l’atmosphère).

Étant donné toutes ces contraintes et tous ces obstacles, la science elle-même devrait être considérée comme une façon de repenser notre monde, mais seulement comme un protocole parmi d’autres et une pratique parmi d’autres. Selon moi, la science devrait être considérée comme une approche spécifique, que j’appellerai artistique dans le sens où les scientifiques — comme d’autres artistes — appliquent, mettent en pratique leur approche particulière dans le monde réel et s’engagent dans leur vision par le biais d’expéditions, réelles ou virtuelles, et d’expériences de pensée (gedankenexperiment). Une fois reconnue la nature performative de la science, elle-même perçue comme une pratique artistique spécifique, une vision partagée et syncrétique des défis posés à la société pourrait émerger, mais seulement au terme d’une confrontation avec d’autres pratiques artistiques, toutes aussi légitimes que la science puisqu’elles ne font qu’utiliser une plus grande variété de récits pour interroger notre perception, notre représentation et notre pensée du monde.

L’art et la science englobent toutes les performances et les récits nécessaires à cette confrontation, interrogent nos croyances et nos observations, mais aussi la nature, la légitimité et l’éthique de notre pratique scientifique sans les restrictions habituelles imposées à la pensée critique par un protocole de preuve quasi sacralisé et donc impossible à remettre en question. Une fois que cette vision commune judicieuse aura été construite par le biais de l’art, de récits scientifiques et de récits résultant de l’association de la science avec l’art, elle devrait imprégner toutes les actions de tous les individus et de toutes les communautés et secondairement, sans doute contribuer à définir et à attribuer à la science un chemin à suivre plus raisonnable, ou tout au moins ramener en son sein la possibilité d’une pensée critique.

Jean-Marc Chomaz

publié dans MCD #79, « Nouveaux récits du climat », septembre / novembre 2015

Jean-Marc CHOMAZ est artiste et scientifique, directeur de recherche au CNRS, professeur à l’École Polytechnique. Il a cofondé le Laboratoire d’Hydrodynamique (LadHyX) en 1990, puis le Laboratoire d’excellence LaSIPS en 2011 et les a co-dirigé respectivement de 1990 à 2013 et de 2011 à aujourd’hui.

(1) www.labofactory.com

(2) Exposition Aquaplanet de Labofactory, Zone2Source, Glazen Huis, Amstelpark Amsterdam 31 mai – 23 aout 2015.

(3) Exposition Lost in Fathoms, Anaïs Tondeur et Jean-Marc Chomaz, recherches menées en commun au LadHyX et présentées à la GV-Art Gallery à Londres en 2014.

(4) Kurt Gödel. On Formally Undecidable Propositions of Principia Mathematica and

Related Systems. Dover, 1962.

Kurt Gödel. « Uber formal unentscheidbare Sätze der Principia Mathematica und

verwandter Systeme I». In Solomon Feferman, editor, Kurt Gödel: Collected Works,

volume 1, pages 144-195. Oxford University Press, 1986. German text, parallel

English translation.